可解释、可审计、透明的AI系统才是我们需要的

时间:2019-11-01 14:54:39 热度:37.1℃ 作者:网络

每个父母都担心他们孩子会受到潜在影响。 比如,他们的老师是谁? 他们正在看什么电影? 他们在玩什么电子游戏? 他们在和合适的人群闲逛吗? 父母们会仔细检查这些事情带来潜在影响,无论是好是坏,因为他们知道这些会影响孩子成长和判断。

正如我们关注谁在教我们的孩子一样,我们也需要注意谁在教我们的算法。 像人类一样,人工智能系统从其所处的环境中学习,并根据其发展的偏见做出决策。 和我们的孩子一样,我们应该期望我们的模型能够随着他们的成长来解释他们的决定。

正如Cathy O’Neil在《数学毁灭性武器》中所解释的那样,算法通常决定着我们上的大学,是否被录用以寻找工作,是否有资格获得贷款以购买房屋,甚至谁入狱以及持续多长时间。 与人为决定不同,这些数学模型很少受到质疑。 它们只是出现在某些人的计算机屏幕上,命运就已确定。

Image result for Weapons of Math Destruction"

在某些情况下,算法的错误是显而易见的,例如当道琼斯报道谷歌以90亿美元收购苹果公司,而机器人为此而屈服时,或者微软的Tay聊天机器人在Twitter上发疯时;但通常不是这样,有些错误并非这么明显。更隐蔽和普遍的是那些细微的小错误,这些细微的小错误虽然未被注意到,但却对人们的生活产生了非常实际的影响。

一旦遇到错误的算法,您的生活就会立即变得更加困难。 无法入读一所好学校或找不到一份工作,您的收入将会减少,生活在更差的社区。 这些事实被引入新算法中,您的情况会进一步恶化。 你的每一次决定,每一个行动,都会被记录下来,然后被进行测量和评估。

以莎拉·怀索克(Sarah Wysocki)为例,她是一名五年级老师,尽管受到父母,学生和管理人员的称赞,但还是被哥伦比亚特区学区开除,原因是一种算法认为她的成绩不及标准。 为什么? 目前尚不清楚,因为系统太复杂了,开除她的人也无法理解。

Image result for sarah wysocki teacher"

毫无疑问,随着我们越来越多地将决策外包给算法,这个问题有可能变得更加严重。 当务之急是,我们必须开始认真对待人工智能偏差问题,并采取措施使我们的系统更加透明,可解释和可审计来减轻其影响。

人工智能系统中的偏差有两个主要来源:训练模型所依据的数据集和模型本身的设计。 训练算法的数据集中的偏差可能很细微,例如,当使用智能手机应用程序监视坑洼并提醒当局与维护人员联系时。 这可能是有效的方法,但在偏远地区一定是行不通的,这是因为那里拥有智能手机的人比较少。

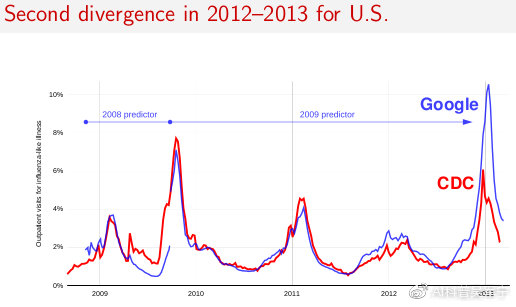

在其他情况下,未收集的数据可能会影响结果。 分析人士怀疑,当Google对2013年流感趋势进行预测的时候,预估病例数几乎是实际数量的两倍时,就会发生这种情况。 似乎已经发生的事情是,媒体报道的增加导致没有生病的人进行更多的搜索。

Image result for Google Flu Trends 2013"

当人类的偏见延续到AI系统中时,就会产生数据偏见的另一个来源。 例如,司法系统中的偏见会影响谁因犯罪被起诉和判刑。 如果将这些数据用于预测谁可能犯罪,那么这些偏见将继续存在。 在其他情况下,人类被用来标记数据,并可能将输入偏差引导到系统中。

这种偏见普遍存在,难以消除。 实际上,亚马逊被迫放弃了由人工智能驱动的招聘工具,因为他们无法消除结果中的性别偏见。 他们不公平地偏爱男性,因为他们使用的培训数据告诉系统,该公司以前雇用的大多数被视为成功的员工都是男性。 即使他们消除了对性别的任何具体提及,系统仍将某些单词出现在男性简历中而不是女性简历中,这是性别的代理。

解决方案

由于存在多种多样的偏见,我们认为完全消除甚至根本消除偏见是不现实的。 但是,我们可以做的是使我们的AI系统更具可解释性,可审计性和透明度。 我们建议领导者可以采取三个实际步骤来减轻偏见的影响。

首先,必须对AI系统进行严格的人工审查。 例如,奥巴马政府在白宫的一份报告中引用的一项研究发现,虽然机器在读取放射线图像时有7.5%的错误率,而人类有3.5%的错误率,但是当人们将工作与机器结合起来时,错误率下降至0.5%。

其次,就像法律要求银行“了解客户”一样,构建系统的工程师也需要了解其算法。 例如,Experian数据实验室负责人埃里克·哈勒(Eric Haller)告诉我们,与几十年前不同,当他们使用的模型相当简单时,在AI时代,他的数据科学家需要更加谨慎。 他说:“过去,我们只需要保留准确的记录,这样,如果犯了一个错误,我们可以回去,找到问题并加以解决。” “现在,当我们有这么多模型都由人工智能提供支持时,这并不容易。 我们不仅可以下载开源代码并运行它。 我们需要非常深入地了解我们算法中的每一行代码,并能够向外部利益相关者进行解释。”

Image result for Eric Haller Experian"

第三,人工智能系统以及用于训练它们的数据源必须透明且可用于审核。 欧洲的GDPR之类的立法框架已迈出了一些有希望的第一步,但显然还需要做更多的工作。 我们认为人类在没有任何监督的情况下做出决定是不可接受的,因此没有理由在机器做出决定时我们应该接受它。

也许最重要的是,我们需要从自动化文化转变为增强文化。 人工智能的效果最好不是用作替代人类并降低成本的魔盒,而是用作创造新价值的助推器。 通过使AI系统更具可解释性,可审计性和透明度,我们不仅可以使我们的系统更加公平,而且可以使它们更有效,更有用。

本文由@AI科普吴军宁 原创翻译,英文原文发表于哈弗商业评论,链接:

https://hbr.org/2019/10/we-need-ai-that-is-explainable-auditable-and-transparent